Инструментальное, или оперантное, обусловливание. Научение: классическое vs. оперантное

ОПЕРАНТНОЕ ОБУСЛОВЛИВАНИЕ

Для понимания сущности закона эффекта Торндайка нам необходимо дать четкое определение понятия «вероятность реакции». Это очень важное понятие, но, к сожалению, очень трудное. При обсуждении поведения человека мы часто апеллируем к тенденциям «расположенности» вести себя определенным образом. Почти в каждой теории поведения используются такие термины, как «потенциал возбуждения», «сила привычки» или «детерминирующая тенденция». Но как мы наблюдаем тенденцию? И как можно ее замерить?

Если бы определенное поведение существовало в двух ипостасях - в одном случае оно всегда бы имело место, а в другом - никогда, то мы оказались бы почти в беспомощном состоянии при введении программы функционального анализа. Феномен, имеющий характеристики «все и ничего», имеет только простые формы описания. Гораздо более продуктивным является предположение, что вероятность осуществления реакции последовательно распределяется между этими двумя полюсами «все - ничего». Тогда мы можем рассмотреть переменные, которые в отличие от стимулов порождения (eliciting stimulus), «не являясь причиной данного поведения», делают его наступление более вероятным. Далее мы можем, например, рассмотреть последствия действия нескольких таких переменных.

Распространенные выражения, отражающие вероятностную природу явления, - «тенденция» или «предрасположенность» - характеризуют частоту наступления определенных видов поведения. Мы никогда не наблюдаем вероятность. Мы говорим, что кто-то «обожает бридж», потому что замечаем, что он часто играет в бридж и часто говорит о нем. «Глубоко интересоваться» музыкой означает много играть, часто слушать музыку и много говорить о музыке. «Неисправимый игрок» много играет в карты. Любитель киносъемок делает снимки, проявляет их и любуется своими собственными снимками и снимками других людей и т. д…

Характеризуя поведение человека с точки зрения его частоты, мы принимаем определенные стандартные условия: он должен быть способен выполнить и повторить определенное действие, при этом другие виды поведения не должны мешать. Например, мы не можем знать, насколько сильна тяга человека к музыке, если ему приходится также заниматься другими вещами. Подойдя к проблеме уточнения научного определения вероятности, мы обнаруживаем, что исходными моментами являются частота и условия, при которых наблюдается то или иное поведение. Мы устраняем или по крайней мере сохраняем в неизменном виде любое условие, которое способствует проявлению конкурирующего с изучаемым нами видом поведения. Животное помещается в отдельный (quiet) ящик, и за его поведением наблюдают с помощью одно-канального экрана, или оно регистрируется посредством специальных технических устройств. Эти условия нельзя рассматривать как вакуумную среду, так как животное будет реагировать на свойства ящика многими способами, однако его поведение постепенно достигнет достаточно устойчивого уровня, на котором можно исследовать частоту заданной реакции.

Для изучения процесса, который Торндайк назвал запечатлением, мы должны иметь его «последствие». Это может быть, например, предъявление еды голодному животному. Мы можем предъявлять нашему испытуемому еду в удобном для него месте, на большом подносе, с помощью специального устройства. При первом предъявлении подноса животное, вероятно, будет реагировать на него различными поведенческими реакциями, которые мешают проявлению изучаемого нами поведения. Постепенно после нескольких кормлений оно без промедления принимает пищу и мы получаем возможность рассматривать это последствие как зависящее от поведения и наблюдать его результат.

Мы выбираем относительно простой вид поведения, который свободно и многократно воспроизводим и который легко поддается наблюдению и регистрации. Например, если испытуемым является голубь, то поднятие им головы выше определенного уровня является удобным поведением для изучения. Оно может быть зафиксировано взглядом экспериментатора на шкале, прикрепленной к задней стенке ящика, на фоне которой находится голубь. Сначала мы изучаем естественную высоту поднятия головы голубем и выбираем на шкале отметку, которая достигается им только в отдельных случаях. Фиксируя свой взгляд на шкале, экспериментатор начинает очень быстро открывать поднос, как только голова поднимается выше этой линии. Если эксперимент проводится в соответствии со спецификациями, то получается один и тот же результат: мы наблюдаем быстрое изменение частоты пересечения головой голубя заданной линии. Мы также видим, что голова голубя поднимается на более высокий уровень, и этот факт имеет большое теоретическое значение. Мы можем очень быстро заставить голубя высоко поднимать голову, установив время предъявления пищи. Через одну-две минуты поза голубя изменяется таким образом, что его голова редко опускается ниже линии, которую мы выбрали вначале.

Когда мы демонстрируем процесс запечатления в такой относительно простой форме, мы видим, что некоторые обычные интерпретации эксперимента Торндайка избыточны. Выражение «научение путем проб и ошибок», которое часто связывается с законом эффекта, здесь явно неуместно. Мы вкладываем особый смысл в наши наблюдения, когда называем любое поднятие головы «пробой», и нет оснований считать «ошибочным» любое движение, которое не приводит к установленному нами результату. Даже употребление термина «научение» вводит в заблуждение. Утверждение, что «птица научается получать пищу посредством вытягивания шеи», является неадекватным выражением того, что происходит. Говорить, что она приобрела «навык» вытягивать шею - значит просто обращаться к объяснительным вымыслам, поскольку единственным доказательством наличия навыка является приобретенная тенденция выполнять действие. Простейшим возможным описанием данного процесса является следующее: мы делаем данный контингент следствий зависимым от определенных физических свойств поведения (поднятия головы), далее фиксируем, что частота появления этого поведения возрастает. Принято рассматривать любое движение живого существа как реакцию. Это слово заимствовано из исследований, посвященных изучению рефлексов. Оно означает действие, которое наступает в ответ на предшествующее событие - стимул. Но мы можем сделать событие зависимым от поведения без определения предшествующего стимула. Мы не изменяем среду обитания голубя для того, чтобы вызвать поднятие головы. Вероятно, нельзя показать, что любой простой стимул неизменно предшествует этому движению. Такое поведение может оказаться под контролем стимулов, но при этом отсутствуют отношения по типу «одно порождает другое», поэтому термин «реакция» не вполне адекватен, но он настолько укоренился, что далее мы будем его использовать.

Конечно, нельзя предсказать и проконтролировать реакцию, которая уже произошла. Можно только предсказать, что похожие реакции будут наблюдаться в будущем. Поэтому единицей науки о прогнозировании является не реакция, а класс реакций. Для его описания будет использоваться слово «оперантный». Данный термин показывает, что поведение «воздействует» (operates) на среду, генерируя последствия. Следствия определяют свойства, по которым устанавливается сходство реакций. Он будет использоваться и как прилагательное (оперантное поведение), и как существительное, обозначающее поведение, определенное данным следствием.

Поднятие голубем головы один раз в определенный момент является реакцией. Это прошлое и его можно рассматривать со всех точек зрения, которые представляют для нас интерес. Поведение, называемое «поднятием головы», которое происходит независимо от определенных обстоятельств (instances), является оперантным. Его можно описать не как завершенное действие, а как состав действий, определяющийся свойствами высоты, на которую нужно поднять голову. В этом смысле оперант можно определить посредством следствия, характеризуемого с помощью физических терминов. «Поднятие головы» («cutoff») на определенную высоту является частью (property) поведения.

Традиционное употребление термина «научение» может быть сохранено для описания перераспределения реакций на классы в сложной ситуации. Терминология, необходимая для описания процесса запечатления, может быть заимствована из теории условных рефлексов И. П. Павлова. Сам Павлов называет все события, которые усиливают поведение «подкреплением» и все возникающие в связи с ним изменения, «обусловливанием». Однако в экспериментах Павлова подкрепление сочетается со стимулом, а при оперантном поведении оно зависит от реакции. Поэтому оперантное подкрепление является специальным процессом и нуждается в специальном анализе. В обоих случаях усиление поведения, происходящее в результате подкрепления, называется «обусловливанием». При оперантном обусловливании мы усиливаем оперант, чтобы увеличить вероятность или частоту появления реакции. В условиях павловского, или «респондентного», обусловливания мы просто повышаем величину реакции, вызванную условным стимулом, и сокращаем время между стимулом и реакцией. Мы уже отмечали, что этими двумя случаями исчерпываются возможности: 1) организм обусловливается, когда подкрепление сопровождает другой стимул или 2) следует за поведением организма. Любое событие, которое не приводит к одному из этих случаев, не влияет на изменение вероятности реакции. Тогда в эксперименте с голубем еда является тем, что подкрепляет, а.ее предъявление, когда реакция «выделяется», является подкреплением. Оперант определяется свойствами, от которых зависит подкрепление - высотой, на которую должна подниматься голова голубя. Изменение частоты поднятия головы на эту высоту есть процесс оперантного обусловливания.

Находясь в состоянии бодрствования, мы постоянно воздействуем на среду, и многие последствия нашего поведения имеют силу подкрепления. Посредством оперантного обусловливания среда конструирует базисный репертуар поведения, благодаря которому мы сохраняем равновесие, ходим, играем в спортивные игры, пользуемся инструментами, говорим, пишем, гребем, управляем автомобилем и самолетом. Мы можем оказаться не готовыми к изменению в среде, например появлению нового автомобиля, нового друга, новых интересов, к смене работы и местожительства, но мы обычно быстро приспосабливаемся к новой обстановке, приобретая новые реакции и утрачивая старые. ‹:…› Оперантное подкрепление не только структурирует репертуар поведения. Оно улучшает продуктивность поведения и еще долгое время сохраняет его после того, как его усвоение или продуктивность теряют свою значимость.

Из книги Думают ли животные? автора Фишель ВернерОперантное обусловливание по Скиннеру Название раздела звучит научно и недоступно. Пусть пока оно так и останется непонятным, поскольку вначале речь пойдет о творческом наследии И. П. Павлова. Труды Павлова получили мировое признание и в 1904 году были отмечены

ОПЕРАНТНОЕ ОБУСЛОВЛИВАНИЕ

ОПЕРАНТНОЕ ОБУСЛОВЛИВАНИЕ. Теория инструментального, или О. о. связана с именами Торндайка (Thorndike E. L.) и Скиннера (Skinner В. F.). В отличие от принципа классического обусловливания (S->R), они разработали принцип О. о. (R->S), согласно которому поведение контролируется его результатами и последствиями. Основной путь воздействия на поведение, исходя из этой формулы, - влияние на его результаты.

Для различения стимула классического условного рефлекса и стимула инструментального условного рефлекса Скиннер предложил обозначать первый как Sd (дискриминантный стимул), а второй - Sr (pecпондентный стимул). Sd - стимул, по времени предшествующий определенной поведенческой реакции, Sr - стимул, подкрепляющий определенную поведенческую реакцию и по времени следующий за ней. Хотя в повседневной жизни эти стимулы часто совмещены в одном объекте, они могут быть разделены путем анализа с целью систематизации и определения последовательности мер воздействия на модифицируемое поведение. При использовании оперантных методов управление результатами поведения осуществляется для воздействия на само поведение. Поэтому здесь очень важен этап функционального анализа или поведенческой диагностики. Задача этого этапа состоит в определении подкрепляющей значимости окружающих пациента объектов, установлении иерархии их подкрепляющей силы. Это делается путем прямого наблюдения за поведением человека и установления связи между частотой и интенсивностью проявляемого поведения (зависимая переменная) и имеющимися в это время объектами и событиями, происходящими в окружении (независимая переменная).

Оперантные методы могут быть использованы для решения ряда задач.

1. Формирование нового стереотипа поведения, которого до этого не было в репертуаре поведенческих реакций человека (например, кооперативное поведение ребенка, поведение самоутверждающего типа у пассивного ребенка и т. д.). Для решения этой задачи может быть использовано несколько стратегий выработки нового поведения.

Под шейпингом понимается поэтапное моделирование сложного поведения, которое не было свойственно ранее индивиду. В цепи последовательных воздействий важным является первый элемент, который, хотя и отдаленно, связан с конечной целью шейпинга, однако с большой степенью вероятности направляет поведение в нужное русло. Этот первый элемент должен быть точно дифференцирован, а критерии оценки его достижения четко определены. Для облегчения проявления первого элемента желательного стереотипа должно быть выбрано условие, которое может быть достигнуто быстрее и легче всего. Для этого используется разнообразное варьирующее подкрепление, от материальных предметов до социального подкрепления (одобрение, похвала и др.). Например, при обучении ребенка навыкам самостоятельного одевания первым элементом может быть привлечение его внимания к одежде.

В случае "сцепления" используется представление о поведенческом стереотипе как о цепи отдельных поведенческих актов, при этом конечный результат каждого акта является дискриминантным стимулом, запускающим новый поведенческий акт. При реализации стратегии сцепления следует начинать с формирования и закрепления последнего поведенческого акта, находящегося ближе всего к самому концу цепи, к цели. Рассмотрение сложного поведения как цепи последовательных поведенческих актов позволяет понять, какая часть цепи хорошо сформирована, а какая должна быть создана с помощью шейпинга. Тренинг должен продолжаться до того момента, пока желательное поведение всей цепи не осуществляется с помощью обычных подкрепляющих стимулов.

Фейдинг - это постепенное уменьшение величины подкрепляющих стимулов. При достаточно прочно сформированном стереотипе пациент должен реагировать на минимальное подкрепление прежним образом. Фейдинг играет важную роль при переходе от тренировок с психотерапевтом к тренировкам в повседневном окружении, когда подкрепляющие стимулы исходят от других людей, замещающих психотерапевта.

Побуждение является вариантом вербального или невербального подкрепления, который повышает у обучающегося уровень внимания и фокусировки на желательном стереотипе поведения. Подкрепление может выражаться в демонстрации этого поведения, прямых инструкциях, центрированных или на нужных действиях, или на объекте действия и т. д.

2. Закрепление уже имеющегося в репертуаре индивида желательного стереотипа поведения. Для решения этой задачи может использоваться положительное подкрепление, отрицательное подкрепление, контроль стимула.

3. Уменьшение или угашение нежелательного стереотипа поведения. Достигается с помощью методик наказания, угашения, насыщения.

4. Лишение всех положительных подкреплений.

5. Оценка ответа.

См. также Бихевиоризм, Поведенческая психотерапия, Положительное и отрицательное подкрепление.

В классическом обусловливании условная реакция часто напоминает обычную реакцию на безусловный стимул. Слюноотделение, например, - нормальная реакция собаки на пищу. Но если вы хотите научить организм чему-то новому, например научить собаку новому трюку, классическое обусловливание вам не поможет. Какой безусловный стимул заставит собаку сидеть или перекатываться? Чтобы обучить собаку, вам придется сначала убедить ее проделать нужный трюк, а потом вознаградить ее похвалой или пищей. Если продолжать так делать, собака со временем научится этому трюку.

Многое из поведения в реальной жизни похоже на это: реакциям научаются потому, что они действуют, или воздействуют на окружение. Такой тип научения, называемый оперантным обусловливанием, свойствен и человеку, и животным. Оставленный один в кроватке, ребенок может спонтанно брыкаться, вертеться или лопотать. Собака, оставшись одна в комнате, может метаться взад-вперед, что-то вынюхивать, может подобрать мячик, уронить его или поиграть с ним. Ни один организм не реагирует на появление или исчезновение конкретного внешнего стимула. Все они воздействуют на свое окружение. Но если организм уже осуществляет определенное поведение, вероятность того, что он повторит это действие, зависит от того, что следует за последним. Ребенок будет чаще лопотать, если за каждым таким действием следует родительское внимание, и собака будет чаще поднимать мячик, если за этим следует ласка или вознаграждение пищей. Если считать, что у ребенка есть цель вызвать родительское внимание, а у собаки цель - пища, то оперантное обусловливание сводится к научению тому, что определенное поведение ведет к достижению определенной цели (Rescorla, 1987).

Закон эффекта

Изучение оперантного обусловливания началось на рубеже нашего века с ряда экспериментов Торндайка (Е. L. Thorndike, 1898). Торндайк, на которого сильно повлияла дарвиновская теория эволюции, стремился показать, что научение у животных неотрывно от научения у человека. Типичный эксперимент проходил так. Голодного кота сажали в клетку, дверца которой была закрыта на простую задвижку, а совсем рядом с клеткой клали кусочек рыбы. Поначалу кот пытался добраться до рыбы, протягивая лапы между прутьев. Когда это не получалось, кот перемещался по клетке, предпринимая самые разные действия. В какой-то момент он случайно задевал задвижку, выходил на свободу и съедал рыбу. Затем кота сажали обратно в клетку и бросали снаружи новый кусочек рыбы. Кот совершал примерно ту же последовательность действий, пока ему опять не удавалось открыть задвижку. Эта процедура повторялась снова и снова. Продолжая пробы, кот отбрасывал многие бесполезные действия, постепенно достигая удачного открывания задвижки и выхода на свободу, как только его помещали в клетку. Этот кот научился открывать задвижку, чтобы получить пищу.

Все это выглядит так, как будто кот действует разумно, но Торндайк утверждал, что здесь присутствует мало «интеллекта». За все время не было такого момента, чтобы у кота появилась догадка о решении этой задачи. Вместо этого достижения кота постепенно улучшались с продолжением проб. Кот не догадывается, а просто ведет себя по типу проб и ошибок, и когда после совершения какого-то действия немедленно следует вознаграждение, научение этому действию закрепляется. Это закрепление Торндайк называл законом эффекта. Он утверждал, что при оперантном научении в силу закона эффекта из набора случайных реакций выбирается та, за которой идут положительные последствия. Этот процесс сходен с эволюцией, в которой закон выживания самого приспособленного выбирает из набора случайных вариаций вида именно те изменения, которые способствуют выживанию этого вида. Закон эффекта, таким образом, провозглашает выживание самых приспособленных реакций (Schwartz, 1989).

Эксперименты Скиннера

Б. Ф. Скиннер - виновник целого ряда изменений в представлениях о том, что такое оперантное обусловливание и как его изучать. Его метод исследования оперантного обусловливания был проще, чем у Торндайка (например, использовалась только одна реакция), и стал широко принятым.

< Рис. Б. Ф. Скиннер явился основоположником изучения оперантного обуславливания.>

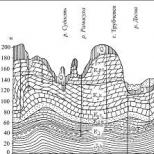

Вариации эксперимента. В эксперименте Скиннера голодное животное (обычно крысу или голубя) помещают в ящик, подобный изображенному на рис. 7.6, с популярным названием «ящик Скиннера».

Рис. 7.6. Устройство для оперантного обусловливания. На фото показан ящик Скиннера с кассетой для подачи пищевых шариков. Компьютер используется для управления экспериментом и регистрации реакций крысы.

Ящик внутри пуст, если не считать выступающего рычага, под которым стоит тарелка для еды. Небольшая лампочка над рычагом может включаться по усмотрению экспериментатора. Оставленная одна в ящике, крыса передвигается и исследует его. Случайно она обнаруживает рычаг и нажимает на него. Частота, с которой крыса вначале нажимает на рычаг, - фоновый уровень. После установления фонового уровня экспериментатор запускает в действие кассету с пищей, расположенную снаружи ящика. Теперь каждый раз, когда крыса нажимает на рычаг, небольшой шарик пищи выпадает в тарелку. Крыса съедает его и вскоре снова нажимает на рычаг; пища подкрепляет нажатие на рычаг, и частота нажатий стремительно растет. Если кассету с пищей отсоединить, так что при нажатии на рычаг пища больше не подается, частота нажатий будет уменьшаться. Следовательно, оперантно обусловленная реакция (или просто операнта) при неподкреплении угасает точно так же, как и классически обусловленная реакция. Экспериментатор может установить критерий дифференцировки, подавая пищу только тогда, когда крыса нажимает на рычаг при горящей лампочке, и тем самым вырабатывая условную реакцию у крысы путем избирательного подкрепления. В этом примере свет служит дифференцировочным стимулом, который контролирует реакцию.

Итак, оперантное обусловливание повышает вероятность некоторой реакции, когда определенное поведение сопровождается подкреплением (обычно в виде пищи или воды). Поскольку в ящике Скиннера рычаг присутствует всегда, крыса может нажимать на него так часто или не часто, как сама выберет. Таким образом, частота реакции служит удобной мерой силы операнты: чем чаще совершается реакция за данный временной интервал, тем больше ее сила.

Следует указать на отношение между терминами «вознаграждение» и «наказание», с одной стороны, и «положительное» и «отрицательное подкрепление», с другой. Термин «вознаграждение» может использоваться синонимично с термином «положительный подкрепляющий фактор» - событие, которое увеличивает вероятность той или иной формы поведения, если оно следует за данной формой поведения. Однако наказание - это не то же самое, что отрицательный подкрепляющий фактор. Термин «отрицательное подкрепление» означает прекращение наступления нежелательных событий, следующих за той или иной формой поведения; как и положительное подкрепление, оно увеличивает вероятность соответствующей формы поведения. Наказание же имеет противоположный эффект: оно уменьшает вероятность наказуемого поведения. Наказание также может быть как положительным (воздействие неприятного стимула), так и отрицательным (лишение положительного стимула) (см. табл. 7.3).

Таблица 7.3. Типы подкрепления и наказания

|

Тип |

Определение |

Эффект |

Пример |

|

Положительное подкрепление |

Приятный стимул, следующий за желательной формой поведения |

Высокая оценка на экзамене |

|

|

Отрицательное подкрепление |

Прекращение воздействия неприятного стимула вслед за желательной формой поведения |

Увеличивает вероятность желательной формы поведения |

Разрешение ребенку пойти погулять после того, как он прекратил истерику |

|

Положительное наказание |

Воздействие неприятного стимула вслед за нежелательной формой поведения |

Низкая оценка на экзамене |

|

|

Отрицательное наказание |

Прекращение воздействия приятного стимула вслед за нежелательной формой поведения |

Уменьшает вероятность нежелательной формы поведения |

Запрещение смотреть телевизор ребенку, который плохо себя ведет |

Применение к воспитанию детей. Хотя в оперантном обусловливании любимыми экспериментальными животными были крысы и голуби, оно применимо ко многим биологическим видам, включая нас самих. Действительно, оно может многое сказать нам о воспитании детей. Особенно ярким примером этому служит такой случай. У маленького мальчика были вспышки гневного раздражения, если он не получал достаточно внимания от родителей, особенно перед сном. Поскольку родители рано или поздно откликались, проявляемое ими внимание подкрепляло гнев ребенка. Чтобы снять эту гневную раздражительность, родителям посоветовали выполнять обычный ритуал укладывания спать, а затем игнорировать протесты ребенка, хотя это и может быть болезненно. При воздержании от подкрепления (уделения внимания) вспышки гнева должны угасать; именно это и произошло. Всего за 7 дней время, в течение которого этот ребенок плакал в постели, сократилось с 45 минут до нуля (Williams, 1959).

< Рис. Склонность детей к истерикам можно ослабить, если их поведение не подкреплять родительским вниманием.>

Еще одно применение оперантного обусловливания к воспитанию детей касается временного соотношения между реакцией и ее подкреплением. Лабораторные эксперименты показали, что немедленное подкрепление более эффективно, чем задержанное; чем больше времени проходит между оперантной реакцией и подкреплением, тем меньше сила реакции. Многие специалисты по психологии развития отмечали, что задержка подкрепления - важный фактор ухода за маленькими детьми. Если ребенок по-доброму относится к домашнему животному, его действия лучше всего можно закрепить вознаграждением (похвалой, например) немедленно, не откладывая это на потом. Сходным образом, если ребенок бьет кого-либо без провокации в свой адрес, то такое агрессивное поведение будет исключено с большей вероятностью, если его наказать немедленно, не откладывая на потом.

Формирование. Предположим, вы хотите использовать оперантное обусловливание, чтобы научить вашу собаку трюку - например, нажимать носом на звонок. Вы не можете ждать, пока собака сделает это сама собой (и тогда подкрепить это), поскольку ждать можно вечно. Если требуемое поведение действительно новое, вы должны обусловить его, используя преимущество естественных вариации в действиях животного. Чтобы научить собаку нажимать звонок носом, можно давать ей пищевое подкрепление каждый раз, когда она приближается к зоне звонка, заставляя ее с каждым подкреплением подходить ближе и ближе к нужному месту, пока наконец нос собаки не коснется звонка. Такая техника, когда подкрепляются только те отклонения в реакциях, которые нужны экспериментатору, называется формированием поведения животного.

Применяя метод формирования, животных можно научить отрабатывать трюки и последовательности действий. Два психолога с сотрудниками подготовили тысячи животных многих видов для телевизионных шоу, рекламы и окружных ярмарок (Breland & Breland, 1966). В одном популярном шоу участвовала «Присцилла, привередливая свинка». Присцилла включала телевизор, ела завтрак за столом, подбирала грязную одежду и клала ее в. корзину, пылесосила пол, выбирала свою любимую еду (среди продуктов, конкурирующих с продукцией ее спонсора!) и принимала участие в викторине, отвечая на вопросы аудитории нажатием на выключатели лампочек, показывавших «да» или «нет». Она не была особо одаренной свиньей: на самом деле, поскольку свиньи растут очень быстро, новую «Присциллу» готовили каждые 3-5 месяцев. Подлинной изобретательностью отличались все же не свиньи, а экспериментаторы, которые использовали оперантное обусловливание и формировали поведение, чтобы добиться желаемого результата. Путем формирования оперантных реакций голубей тренировали находить людей, потерявшихся в море (рис. 7.7), а морских свинок тренировали находить подводное оборудование.

< Рис. Оперантное обусловливание и формирование поведения используются в дрессировке животных для обучения их выполнению различного рода трюков.>

Рис. 7.7 Поиск и спасение с помощью голубей. Береговая охрана использовала голубей для поиска людей, потерявшихся в море. Применяя методы формирования, голубей тренировали распознавать оранжевый цвет - международный цвет спасательных жакетов. Три голубя пристегнуты в ящике из оргстекла, прикрепленном к днищу вертолета. Ящик поделен на секции, так что каждая птица смотрит в своем направлении. Когда голубь обнаруживает оранжевый объект или любой другой объект, он клюет ключ, и у пилота звенит звонок. Тогда пилот разворачивается в направлении, указанном среагировавшей птицей. Для обнаружения удаленных объектов в море голуби подходят больше, чем люди. Они могут смотреть на воду в течение долгого времени, не страдая от усталости глаз: у них превосходное цветовое зрение, а зона фокусировки у них 60-80 градусов, тогда как у человека - 2-3 градуса (по: Simmons, 1981).

Феномены и их применение

Существует ряд явлений, значительно расширяющих сферу действия оперантного обусловливания и указывающих на возможное его применение к поведению человека.

Условное подкрепление. Большинство из рассмотренных нами подкреплений называются первичными, поскольку, как и пища, они удовлетворяют основные потребности. Если бы оперантное обусловливание происходило только с первичными подкреплениями, оно не было бы таким распространенным в нашей жизни, поскольку первичные подкрепления не столь часты. Однако практически любой стимул может стать вторичным, или условным, подкреплением, если его последовательно сочетать с первичным подкреплением; условные подкрепления значительно расширяют диапазон оперантного обусловливания (так же как обусловливание второго порядка значительно расширяет диапазон классического обусловливания).

Небольшая вариация типичного эксперимента по оперантному обусловливанию иллюстрирует работу условного подкрепления. Когда крыса в ящике Скиннера нажимает на рычаг, моментально звучит тон, за которым вскоре дается пища (пища - первичное подкрепление; звук станет условным подкреплением). После того как у животного выработалась условная реакция, экспериментатор переходит к ее угашению, так что когда крыса нажимает на рычаг, не появляется ни пищи, ни звука. Через какое-то время крыса перестает нажимать на рычаг. Затем возобновляется звук, но не пища. Когда животное обнаруживает, что при нажатии рычага включается звук, частота нажатий заметно возрастает, преодолевая угасание, хотя никакой еды за этим не следует. Звук приобрел качество подкрепления сам по себе путем классического обусловливания; устойчиво сочетаясь с пищей, он сам стал сигналом пищи.

Наша жизнь изобилует условными подкреплениями. Доминируют из них два: деньги и похвала. Предположительно, деньги являются сильным подкреплением потому, что они часто сочетаются с первичными подкреплениями: можно купить пищу, выпивку, удобства - это только несколько очевидных примеров. И похвала - даже без обещания первичного подкрепления - может во многом поддерживать деятельность.

< Рис. Похвала является эффективным подкрепляющим фактором для многих людей.>

Генерализация и дифференцировка. То, что было верно для классического обусловливания, верно и для оперантного: организмы генерализуют то, что они выучили, и генерализацию можно ограничить тренировкой на дифференцировку. Если родители подкрепляют маленького ребенка за ласкание домашней собачки, он вскоре генерализует эту реакцию ласки на других собак. Поскольку это может быть опасно (соседская собачка может оказаться свирепым сторожевым псом), родители ребенка могут провести некоторую дифференцировочную тренировку, так чтобы он ласкал свою собаку, но не соседскую.

Дифференцировочная тренировка будет эффективна в той степени, в какой присутствует дифференцируемый стимул (или набор стимулов), позволяющий четко отличать случаи, где реакция должна иметь место, от случаев, где ее нужно подавить. Вышеупомянутому маленькому ребенку будет легче научиться, какую собаку ласкать, если его родители смогут указать на признак собаки, сигнализирующий о ее дружественности (виляние хвостом, например). Вообще, дифференцировочный стимул будет полезен в той степени, в какой его присутствие предсказывает, что за реакцией последует подкрепление, а его отсутствие предсказывает, что за реакцией подкрепления не последует (или наоборот). Так же, как и в классическом обусловливании, предсказательная сила стимула имеет решающее значение для обусловливания.

Режимы подкрепления. В реальной жизни отдельные эпизоды поведения подкрепляются редко; иногда за усердную работу хвалят, но часто она остается непризнанной. Если бы оперантное обусловливание происходило только при постоянном подкреплении, его роль в нашей жизни была бы ограниченной. Оказывается, однако, что после того как поведение возникло, оно может поддерживаться, если его подкреплять только часть всего времени. Это явление известно как частичное подкрепление, и его можно проиллюстрировать в лаборатории на примере голубя, который научается клевать ключ, чтобы получать пищу. После того как эта операнта сформировалась, голубь продолжает клевать ключ с высокой частотой, даже если он получает подкрепление только от случая к случаю. Иногда голуби, вознаграждавшиеся пищей в среднем один раз за 5 минут (12 раз в час), клевали ключ 6000 раз в час! Кроме того, угасание, следующее за поддержанием реакции на частичное подкрепление пищей, идет гораздо медленнее, чем угасание, следующее за поддержанием реакции на непрерывное подкрепление. Это явление известно как эффект частичного подкрепления. Данный эффект понятен на чисто интуитивном уровне, поскольку если подкрепление для поддержания реакции является лишь частичным, случаи угасания и поддержания реакции труднее отличить друг от друга.

Когда подкрепление осуществляется только часть всего времени, нам нужно знать, каков в точности его распорядок: после каждой третьей реакции? или каждые пять секунд? Оказывается, что режим подкрепления определяет схему реагирования. Некоторые расписания подкрепления называют пропорциональным режимом, потому что при этом подкрепление зависит от числа совершенных реакций. Это как на заводе, когда рабочему платят за определенный объем работы. Коэффициент пропорциональности может быть фиксированным или переменным. При режиме с фиксированной пропорцией (его называют режимом ФП) число реакций, которые должны совершиться, равно определенной величине. Если это число составляет 5 (ФП 5), то это значит, что подкрепление последует по совершении 5 реакций, если оно равно 50 (ФП 50), потребуется совершить 50 реакций, и т. д. Вообще, чем выше пропорция, тем с большей частотой организм реагирует, особенно если его первоначально тренировали при относительно низком коэффициенте (скажем, ФП 5), а затем непрерывно увеличивали коэффициент до величины, скажем, ФП 100. Это как если бы на заводе рабочему сначала платили по 5 долларов за каждые 5 зашитых швов, но потом настали тяжелые времена, и ему пришлось за те же 5 долларов делать 100 швов. Но, пожалуй, самая примечательная особенность поведения при режиме с ФП состоит в том, что сразу после очередного подкрепления в росте реакций наступает пауза (см. левую часть рис. 7.8). Заводскому рабочему трудно начать новую серию швов сразу после того, как он сделал их достаточно, чтобы получить вознаграждение.

Рис. 7.8. Типичные схемы реакций на четыре основные режима подкрепления. Каждая кривая отображает совокупное число реакций животного в зависимости от времени; наклон кривой отражает частоту его реакций. Кривые слева относятся к пропорциональному режиму. Обратите внимание на горизонтальные участки кривой для режима с ФП: они соответствуют паузам (нет роста совокупного числа реакций). Кривые справа отображают условия интервального режима. Кривая для режима с фиксированным интервалом (ФИ) опять содержит горизонтальные участки, соответствующие паузам (по: Schwartz, 1989). ФП - фиксированная пропорция; ПП - переменная пропорция, ФИ - фиксированный интервал; ПИ - переменный интервал.

При режиме с переменной пропорцией (ПП) подкрепление также дается после совершения определенного количества реакций, но их число варьируется непредсказуемо. Так, при режиме ПП 5 количество реакций, требуемых для подкрепления, иногда составляет 1, иногда 10, а в среднем 5. В отличие от поведения при режиме с ФП, при режиме с ПП не наблюдается пауз в росте реакций (см. левую часть рис. 7.8), предположительно потому, что у организма нет возможности определить, что подкрепление появится нескоро. Хороший пример режима с ПП в повседневной жизни - работа игрового автомата. Количество реакций (игр), необходимое для выдачи подкрепления (выигрыша), все время меняется, и у игрока нет способа предсказать, когда последует подкрепление. Режим ПП может порождать очень высокую частоту реакций (как, видимо, и рассчитали владельцы казино).

Помимо пропорциональных существуют интервальные режимы, в которых подкрепление выдается только по прошествии определенного времени. Такие режимы тоже бывают фиксированными и переменными. При фиксированном интервале (ФИ) организм получает подкрепление за первую реакцию по прошествии определенного времени с момента ее последнего подкрепления. Например, при режиме ФИ 2 (2 минуты) подкрепление дается только по истечении 2 минут после последней подкрепленной реакции; реакции в течение этого двухминутного интервала проходят без последствий. Особенность реагирования при режиме ФИ - пауза, возникающая сразу после подкрепления (она может быть даже длиннее, чем пауза при режиме ФП). Еще одна особенность реагирования при режиме ФИ - это возрастание частоты реакций по мере приближения окончания периода (см. правую часть рис. 7.8). Хороший пример режима ФИ в повседневной жизни - доставка почты, которая приходит только раз в день (ФИ 24 часа) или, в некоторых местах, дважды в день (ФИ 12 часов). Так, сразу после доставки почты вы не будете ее проверять снова (у вас пауза), но по мере приближения окончания интервала доставки почты вы снова начинаете ее проверять.

При режиме с переменным интервалом (ПИ) вознаграждение все еще зависит от прошествия определенного интервала, но его длительность колеблется непредсказуемо. При расписании ПИ 10 (10 минут), например, критический интервал иногда может быть 2 минуты, иногда 20 и т. д. при средней величине 10 минут. Если при режиме ФИ частота реакций меняется, то при режиме ПИ 1 организмы реагируют с одинаково высокой частотой (см. правую часть рис. 7.8). В качестве примера режима ПИ в повседневной жизни можно привести дозванивание по занятому номеру. Чтобы получить подкрепление (дозвониться), надо подождать какое-то время после последней реакции (набора номера); сколько придется ждать в целом - непредсказуемо (см. табл. 7.4).

Таблица 7.4. Режимы подкрепления

|

Пропорциональные режимы |

|

|

Режим с фиксированной пропорцией |

Подкрепление дается после определенного количества реакций |

|

Режим с переменной пропорцией |

Подкрепление дается после определенного количества реакций, количество которых непредсказуемо варьируется |

|

Интервальные режимы |

|

|

Режим с фиксированным интервалом |

Подкрепление дается через определенное время, прошедшее после предыдущего подкрепления |

|

Режим с переменным интервалом |

Подкрепление дается через определенное время, прошедшее после предыдущего подкрепления, при этом продолжительность интервалов непредсказуемо варьируется |

Обусловливание неприятными стимулами

Мы говорили о подкреплении так, будто оно всегда положительное (пища, например). Но отрицательные или неприятные события, например удар током или невыносимый шум, тоже часто используются для обусловливания. Существуют различные виды обусловливания неприятными стимулами, в зависимости от того, применяются ли они для ослабления имеющейся реакции или для заучивания новой. [ Стоит обратить внимание на соотношение терминов вознаграждение и наказание, с одной стороны, и положительное и отрицательное подкрепление, с другой. Вознаграждение может использоваться как синоним положительного подкрепления - события, появление которого вслед за реакцией повышает вероятность этой реакции. Но наказание - это не то же самое, что отрицательное подкрепление. Последнее означает прекращение неприятного события вслед за реакцией. Наказание имеет противоположный эффект: оно уменьшает вероятность реакции. - Прим. автора.]

Наказание. При тренировках с наказанием за реакцией следует неприятный стимул или событие, что ведет к ослаблению реакции или подавлению последующих ее проявлений. Предположим, маленький ребенок, который учится пользоваться цветными карандашами, начинает рисовать на стене (это нежелательная реакция); если его шлепают по руке, когда он это делает (наказание), он научается так не делать. Сходным образом, если крыса, которая учится проходить лабиринт, получает удар током каждый раз, когда она идет не туда, она скоро научится избегать прошлых ошибок. В обоих случаях наказание используется для снижения вероятности нежелательного поведения. [ Другими словами, происходит угасание ориентировочной реакции на безусловный стимул. - Прим. ред.]

Наказание может подавить нежелательную реакцию, но у него есть несколько недостатков. Во-первых, его эффект не столь предсказуем, как эффект вознаграждения. Вознаграждение, по сути, говорит: «Повтори то, что ты уже сделал»; наказание говорит «Перестань!» и не может предложить альтернативу. В результате организм может заменить наказываемую реакцию еще менее желательной. Во-вторых, побочные результаты наказания могут оказаться вредными. Наказание часто ведет к антипатии или страху перед наказывающим человеком (родителем, учителем или нанимателем) и перед самой ситуацией (домом, школой или офисом), где происходило наказание. Наконец, крайне суровое или болезненное наказание может вызвать агрессивное поведение, более серьезное, чем первоначальное нежелательное.

Эти предостережения не означают, что наказание никогда не должно применяться. Оно может эффективно снимать нежелательную реакцию, если другая реакция вознаграждается. Крысы, которые научились находить более короткий из двух путей в лабиринте, чтобы добраться до пищи, быстро переключаются на более длинный, если в коротком пути их бьет током. Временное подавление, вызываемое наказанием, дает крысе возможность научиться идти длинным путем. В этом случае наказание служит эффективным средством переориентировать поведение, поскольку оно информативно, а это и есть ключ к гуманному и эффективному применению наказания. Ребенок, который получил удар током от электроприбора, может научиться тому, какие соединения безопасны, а какие - нет.

< Рис. Угроза наказания - эффективное средство мотивации. Надпись на дорожном знаке: НЕ СИГНАЛИТЬ. Штраф 50$.>

Избегание и предотвращение. Неприятные события могут также использоваться при научении новым реакциям. Организм может научиться реагировать так, чтобы прекратить неприятное событие, например, когда ребенок научается закрывать кран, чтобы горячая вода не лилась в его ванну. Это называется научением избеганию событий. Организм может реагировать и так, чтобы предотвратить неприятное событие до его начала, например, когда мы научаемся останавливаться на красный свет, чтобы предотвратить несчастные случаи (и получение штрафных квитанций). Это называется научением предотвращению событий.

Научение избеганию часто предшествует научению предотвращать события. Это иллюстрирует следующий эксперимент. Крысу помещают в ящик, состоящий из двух отделений, разделенных барьером. В каждой пробе животное помещают в одно из отделений. В некоторый момент звучит предупреждающий звук, а пять секунд спустя к полу этого отделения подается ток; чтобы уйти от удара током, животное должно перепрыгнуть через барьер в другое отделение. Первоначально животное делает это, когда ток уже включен, - здесь имеет место научение избеганию. Но по мере тренировки животное научается прыгать, услышав предупредительный звук, и тем самым целиком избегает удара током - это научение предотвращению.

Научение предотвращению вызвало широкий интерес, отчасти потому, что в нем есть что-то весьма загадочное. Что представляет собой подкрепление реакции предотвращения? В вышеизложенном исследовании - что подкрепляет прыжок крысы через барьер? Интуитивно кажется, это - отсутствие раздражения током, но отсутствие чего-то можно рассматривать как несобытие. Как может несобытие служить подкреплением? В одном из решений этой загадки предполагается, что в таком научении есть две стадии. На первой стадии происходит классическое обусловливание: при неоднократном сочетании предупреждения (УС) и наказующего события, то есть удара током (БУС), животное заучивает реакцию страха на предупреждение. На второй стадии происходит оперантное обусловливание: животное научается, что определенная реакция (перепрыгивание барьера) устраняет неприятное событие, то есть страх. Короче, то, что поначалу кажется несобытием, на самом деле - страх, и предотвращение можно представлять как прекращение страха (Rescorla & Solomon, 1967; Mowrer, 1947).

Контроль и когнитивные факторы

В нашем анализе оперантного обусловливания подчеркивалась роль факторов окружения: за реакцией неизменно следовало подкрепляющее событие, и организм научался ассоциировать данную реакцию с данным подкреплением. Но в когнитивной теории предотвращения, о которой мы говорили, предполагается, что в оперантном обусловливании, так же как и в классическом, важную роль играют когнитивные факторы. Как мы увидим, иногда полезно рассмотреть ситуацию оперантного обусловливания организма как приобретение им нового знания о взаимосвязи между реакцией и подкреплением.

Одновременность или контроль? Как и в случае классического обусловливания, мы хотим знать, какой фактор является решающим, чтобы произошло оперантное обусловливание. Опять-таки один из вариантов - совпадение по времени: операнта становится условной, когда подкрепление немедленно следует за поведением (Skinner, 1948). Более когнитивный вариант ответа, близко связанный с предсказуемостью, - это фактор контроля: операнта становится условной, только когда организм интерпретирует подкрепление как событие, контролируемое его реакцией. Некоторые важные эксперименты (Maier & Seligman, 1976) больше говорят в пользу фактора контроля, чем в пользу фактора совпадения по времени (см. также обсуждение контроля и стресса в гл. 15).

Основной эксперимент состоит из двух стадий. На первой стадии некоторые собаки узнают, что раздражение током или его отсутствие зависит от их поведения (или контролируется им), а другие собаки научаются тому, что у них нет контроля над раздражением током. Собак испытывают парами. Оба члена пары находятся в упряжи, ограничивающей их движения, и неожиданно они получают удар током. Один член пары - «ведущая» собака - может выключить электричество, нажав носом на рядом расположенный выключатель; другой член пары - «ведомая» собака - никак не может контролировать удар током. Каждый раз, когда ведущая собака получает удар, то же достается и ведомой собаке; и каждый раз, когда ведущая собака выключает ток, у ведомой собаки он тоже прекращается. Таким образом, и ведущая и ведомая собаки получают одинаковое количество ударов током.

Чтобы узнать, что выучили собаки на первой стадии, нужна вторая стадия, на которой экспериментатор помещает обеих собак в новое устройство - ящик, разделенный барьером на две половины. Это такое же устройство для теста на предотвращение события, какое мы рассматривали немного выше. Как и ранее, в каждой пробе сначала звучит тон, указывающий, что отделение, занимаемое сейчас животным, вот-вот подвергнется воздействию электричества; чтобы избежать раздражения, животное должно научиться при предупреждающем звуке прыгать через барьер в другое отделение. Ведущие собаки быстро научаются этой реакции. Но с ведомыми собаками происходит совсем иное. Они с самого начала не делают движения через барьер, и по мере продолжения проб их поведение становится все более пассивным, пока собака под конец не впадает в полную беспомощность. Почему? Потому что на первой стадии ведомые собаки узнали, что удары током - вне их контроля, и это убеждение в бесконтрольности сделало обусловливание на второй стадии невозможным. Если убеждение в бесконтрольности делает невозможным оперантное обусловливание, то, может быть, именно убежденность в контроле делает его возможным. Многие другие эксперименты свидетельствуют в пользу того, что оперантное обусловливание происходит, только когда организм воспринимает подкрепление как нечто, что он может контролировать (Seligman, 1975). Подробнее о приобретенной беспомощности будет сказано в гл. 15.

Научение зависимости. О приведенных результатах молено говорить и в терминах зависимостей. Можно сказать, что оперантное обусловливание происходит только тогда, когда организм воспринимает зависимость между своими реакциями и подкреплением. На первой стадии упомянутого выше исследования соответствующая зависимость имела место между нажатием выключателя и окончанием раздражения током; восприятие этой зависимости равнозначно выяснению того, что, когда выключатель нажат, вероятность окончания раздражения больше, чем когда он не нажат. Собаки, которые не воспринимают этой зависимости на первой стадии эксперимента, не ищут никаких зависимостей и на второй стадии. В свете фактора зависимости ясно, что эти результаты изучения оперантного обусловливания сходятся с данными о роли предсказуемости в классическом обусловливании: знание, что УС предсказывает БУС, можно интерпретировать как выражение того, что организм обнаружил зависимость между этими двумя стимулами. Таким образом, и в классическом, и в оперантном обусловливании организм усваивает именно зависимость между двумя событиями. В классическом обусловливании поведение определяется конкретными стимулами; в оперантном обусловливании поведение определяется конкретными ожидаемыми реакциями.

Наша способность узнавать зависимости развивается очень рано, как показывает следующее исследование 3-месячных младенцев. Все младенцы в эксперименте лежали в своих кроватках, головы на подушках. Под каждой подушкой был выключатель, который замыкался каждый раз, когда младенец поворачивал голову. Для испытуемых контрольной группы каждый раз, когда они поворачивали голову и замыкали выключатель, на противоположной стороне кроватки включалась движущаяся игрушка. Для этих младенцев имела место зависимость между поворотом головы и движением игрушки: с поворотом головы движение игрушки было более вероятным, чем без него. Эти младенцы быстро научились поворачивать голову и реагировали на движение игрушки знаками радости (они улыбались и лопотали). Совсем другая картина была у испытуемых экспериментальной группы. Для этих младенцев игрушка приводилась в движение примерно так же часто, как и у контрольных испытуемых, но двигалась она или нет - было вне их контроля: здесь отсутствовала зависимость между поворотами головы и движением игрушки. Эти младенцы не научились двигать головой более часто. Кроме того, через какое-то время они уже не демонстрировали признаков удовольствия от движения игрушки. При отсутствии контроля над ней игрушка, видимо, потеряла часть своей подкрепляющей функции.

Биологические ограничения

Как и в случае классического обусловливания, биология накладывает ограничения на то, что можно выучить путем оперантного обусловливания. Эти ограничения касаются соотношений между реакцией и подкреплением. Для иллюстрации рассмотрим голубей в двух экспериментальных ситуациях: научение с вознаграждением, когда животное приобретает реакцию, подкрепляемую пищей, и научение с прекращением, когда животное приобретает реакцию, подкрепляемую прекращением ударов током. В случае с вознаграждением голуби учатся гораздо быстрее, если в качестве реакции нужно клюнуть ключ, а не хлопать крыльями. В случае с прекращением раздражения током происходит наоборот: голуби учатся быстрее, если условная реакция - это хлопанье крыльями, а не клевание (Bolles, 1970).

Как и в случае классического обусловливания, приведенные результаты расходятся с предположением, что во всех ситуациях работают одни и те же законы научения, и этологически это вполне понятно. Случай с вознаграждением, когда пища сочетается с клеванием (но не хлопанием крыльев), является частью естественной активности птиц, связанной с едой. Значит, разумно предположить, что существует генетически заданная связь между клеванием и едой. Сходным образом, в варианте с прекращением раздражения током имеется опасная ситуация, а естественной реакцией голубя на опасность является хлопанье крыльями (но не клевание). Как известно, у птиц небольшой репертуар оборонительных реакций, и они быстро учатся прекращению только в том случае, если соответствующая реакция принадлежит к естественным оборонительным.

Описанные выше этологические исследования демонстрируют нам новый возможный способ взаимодействия биологического и психологического подходов. Этологические концепции помогают нам придать смысл полученным ранее результатам психологических исследований. Например, они объясняют нам, почему голуби обучаются быстрее в ситуации, включающей вознаграждение, если реакцией является клевание, однако в ситуации, включающей избегание, они обучаются быстрее, если реакцией является хлопание крыльями.

Оперантное обусловливание . В цирке дрессировщики побуждают зверей совершить какое-то действие, а затем хвалят их и дают маленький кусочек пищи. После того как животное научилось делать это новое действие, его побуждают к совершению следующего действия. Если действие не то, которое нужно дрессировщику, то он не дает животному кусочка пищи, т. е. не поощряет его. Животное начинает совершать разные попытки и в итоге реализует нужное действие.

· Оперантное обусловливание -научение, в ходе которого приобретение нового опыта и реализация его в поведении приводят к достижению определенной цели.

Если мы понаблюдаем за поведением собственной собаки, когда она во дворе играет с мячом, то мы заметим, что она может его кусать, прижимать к земле и отпускать или подкидывать его. В естественных условиях обитания организмы не только отвечают на стимулы, но и воздействуют на среду. Но как только организм совершил новое действие, дальнейшее появление этого действия в поведенческом репертуаре будет зависеть от того, каков был его результат. Так, собака чаще будет подбрасывать мяч, если мы будем поощрять это действие поглаживанием или кусочком лакомой пищи.

Оперантное обусловливание (от лат. о peratic - действие) означает такое научение, в ходе которого приобретение определенного нового опыта и реализация его поведении приводят к достижению определенной цели. Оно позволяет нам воздействовать на среду и присуще не только людям, но и более простым существам, так как паук или таракан. Сам термин был введен Б. Ф. Скиннером, хотя процедуру o п e рантного обусловливания использовали веками для дрессировки животных. У Скиннера также был предшественник, который вплотную приблизился к описанию этой формы научения.

На рубеже XIX и XX вв. американский исследователь Э. Торндайк пытался выяснить, существует ли у животных разум, или интеллект. Для этого он построил «проблемный ящик» (рис. 6-2), в который помещал голодных котов. Вне клетки находилась пища, как правило, рыба. Животное могло открыть дверку ящика только в том случае, если оно нажало на педаль внутри ящика или потянуло за рычаг. Но коты вначале пытались достать приманку, просовывая лапы сквозь решетку клетки. После серии неудач они обычно обследовали все внутри, производили разнообразные действия. В конце концов животное наступало на рычаг, и дверка открывалась. В результате многочисленных повторных процедур животные постепенно переставали совершать лишние действия и сразу нажимали на педаль.

Торндайк назвал это научением путем проб и ошибок, поскольку перед тем как животное научается совершать нужный акт, оно реализует множество ошибочных. Такое научение можно представить графически. На рис. 6-3 изображен график, или кривая научения, где по линии абсцисс отложено количество процедур, а по линии ординат - время, за которое животное открывает дверку. Но нему можно увидеть, что чем больше раз животное попадало в проблемный ящик, тем быстрее оно оттуда выходило или, другими словами, тем меньше совершалось ошибок перед реализацией нужного действия.

Важно остановиться на одном моменте, который был отмечен американским исследователем и возведен в ранг закона. Он обнаружил, что те действия, которые поощряются, т. е. подкрепляются, с большей вероятностью возникали в последующих пробах, а те, которые не подкреплялись, не использовались животным в последующих пробах. Другими словами, животное научалось совершать только те действия, за которыми следовало подкрепление - это и есть закон эффекта.

Каковы же были выводы Торндайка по поводу разумного поведения животных? Исследователь отрицал наличие у них каких-либо признаков интеллекта, так как научение происходит путем «слепых» проб и ошибок, а механизм научения заключается в установлении связей между стимулами и реакциями. Не вдаваясь в теоретические подробности, отметим только, что уже упоминавшееся направление - бихевиоризм - стало формироваться после публикации работ Торндайка.

Самый радикальный представитель бихевиоризма, Б. Ф. Скиннер, полагал, что оперантное поведение спонтанно и возникает без каких-либо очевидных стимулов, а реактивное поведение является следствием какого-то стимула. Оперантное поведение можно модифицировать путем подкрепления. По сути, поведение можно контролировать и им можно управлять, создав соответствующий порядок подкрепления. Скиннер много экспериментировал, в основном с крысами и голубями, и утверждал, что закономерности научения одинаковы как для животных, так и для человека.

Разберем типичный эксперимент Скиннера. Голодного голубя сажают в так называемый «ящик Скиннера» (рис. 6-4). Внутри ящика нет ничего, кроме кнопки и находящейся под ней кормушки. Голодная птица, попав в клетку, начинает все обследовать, рассматривать и в результате ударяет клювом по кнопке. Опять повторяется поиск: голубь клюет пол или кормушку, в итоге опять клюет кнопку. Так животное в течение некоторого времени несколько раз клюет кнопку. Количество клеваний по кнопке, скажем, за полчаса, условно принимают за исходный оперантный уровень. Далее включают кормушку, и теперь голубь после каждого удара по кнопке получает зернышко. Через некоторое время птица научается клевать кнопку, так как это действие подкрепляется. Чем больше она клюет кнопку, тем больше она получает пищи. Если голубь будет клевать кнопку с высокой частотой, то это действие характеризуется высоким оперант ным уровнем, если будет клевать ее редко, то действие будет иметь низкий оперантный уровень.

Оперантный уровень, таким образом, показывает уровень обученности подкрепляемому акту. Но что будет, если перестать подавать подкрепление? Как и в классическом обуславливании, произойдет угасание оперантного поведения. Приведем пример. Маленький мальчик проявлял истерические формы поведения, если родители не уделяли ему нужного внимания, особенно перед сном. Так как родителей такое поведение сильно тревожило, они все время успокаивали его и этим подкрепляли дальнейшее появление истерики. Им посоветовали перестать обращать внимание на ребенка, как бы сильно ни плакал. Отмена подкрепления в форме внимания должна была привести к угнетению, т. е. к исчезновению всех истерических проявлений, что и произошло. Плач мальчика исчез уже через одну неделю.

Процедуру оперантного обусловливания применяют для научения животных сложным формам поведения, которые не возникли бы в естественных условиях. Например, медведя можно научить водить мопед, а дельфина - прыгать через горящий круг. Поведение такой сложности можно выработать у животных, применяя процедуру формирования поведения. Для примера приведем ситуацию научения кролика потягиванию кольца.

В небольшой клетке в одном углу находится автоматическая кормушка, напротив, в другом углу, - кольцо. Голодный кролик, попав в клетку, в первые минуты все обнюхивает, становится на задние лапы и выглядывает из клетки. Экспериментатор начинает подавать кормушку с пищей. Кормушка работает с шумом, поэтому животное не сразу залезает в нее. После того как кролик привык к шуму, он уже связывает его с появлением пищи и смело залезает в кормушку за ней. Через некоторое время перестают подавать пищу, после чего кролик вновь начинает осуществлять поисковое поведение. Когда животное поворачивает в сторону кольца, снова подают кормушку с пищей. После множества реализаций поворота кролику начинают давать пищу только в том случае, если он подходит к кольцу. Когда подход к кольцу сформирован, опять перестают подавать пищу. Животное начинает поисковое поведение, повторяет все формы выученных ранее актов, начинает грызть кольцо и тянет его. Срабатывает кормушка. Через некоторое время животное уже научается потягиванию за кольцо.

В оперантном научении особую роль занимает подкрепление. Подкреплением называется любой предмет или событие, которое значимо для организма и ради достижения которого им совершается поведение. Выделяют положительное подкрепление и отрицательное подкрепление. В качестве положительного подкрепления всегда выступают биологически необходимые для организма объекты, например пища, вода, половой партнер и т. д. У людей к биологически необходимым объектам добавляются продукты культуры или культурные ценности. Отрицательное подкрепление опасно для жизни, поэтому организм пытается избежать его или предотвратить его действие. В качестве отрицательного подкрепления исследователи часто используют электрический ток или громкий звук, а процедуру научения в таких случаях принято называть аверзивным обусловливанием (от англ. aversive - отвращающий).

· Подкрепление - предмет или событие, которое значимо для организма.

Теперь нам становится понятно, почему Скиннер полагал, что поведением можно манипулировать через подкрепление. Но на самом деле все оказалось гораздо сложнее. Мак-Фарленд сообщает, что некоторые исследователи пытались научить цыплят стоять спокойно на ровной площадке, чтобы получить вознаграждение, но те все время скребли пол. Другие пытались научить свинью вкладывать в копилку особую монету. Но свинья ни за какое подкрепление не хотела научиться этому, она многократно роняла на пол монету и поднимала опять. Проводили также исследования с голубями, в ходе которых их обучали клевать кнопку либо взмахивать крыльями. Оказалось, что птицы быстрее научались клевать кнопку, если в качестве подкрепления выступала пища (положительное подкрепление), а взмахивать крыльями - если этим поведением они избегали удара электрического тока (негативное подкрепление). С точки зрения Скиннера, голуби должны были научиться клевать кнопку или встряхивать крыльями независимо от рода подкрепления.

Такой парадокс объяснили этологи - исследователи поведения животных в естественных условиях. У голубей акт клевания является частью пищевого поведения, поэтому голубь быстрее научается клевать кнопку, если за этим следует подкрепление в виде пищи. А взмахивание крыльями является частью избегательного поведения, так как птицы совершают этот акт перед тем как взлететь. Ограничения такого рода показывают, что научение связано с имеющимся опытом животного, а также с врожденными формами поведения.